- パソコン(PC)通販のドスパラ

- VRゴーグルがなくてもVR体験が可能になる!? プレスセミナー『VR/ARの現状と未来への展望』レポート

VRゴーグルがなくてもVR体験が可能になる!? プレスセミナー『VR/ARの現状と未来への展望』レポート

IEEEはプレスセミナー『VR/ARの現状と未来への展望』を2017年2月16日に開催した。講演者はIEEE メンバーで、東京大学先端科学技術研究センターの稲見昌彦教授。稲見教授は人工現実感(VR)と拡張現実感(AR)の最新情報を記者たちに紹介した。レポートする。

東京大学先端科学技術研究センター 稲見昌彦教授

■身体性の理解と再設計を狙う稲見・檜山研究室

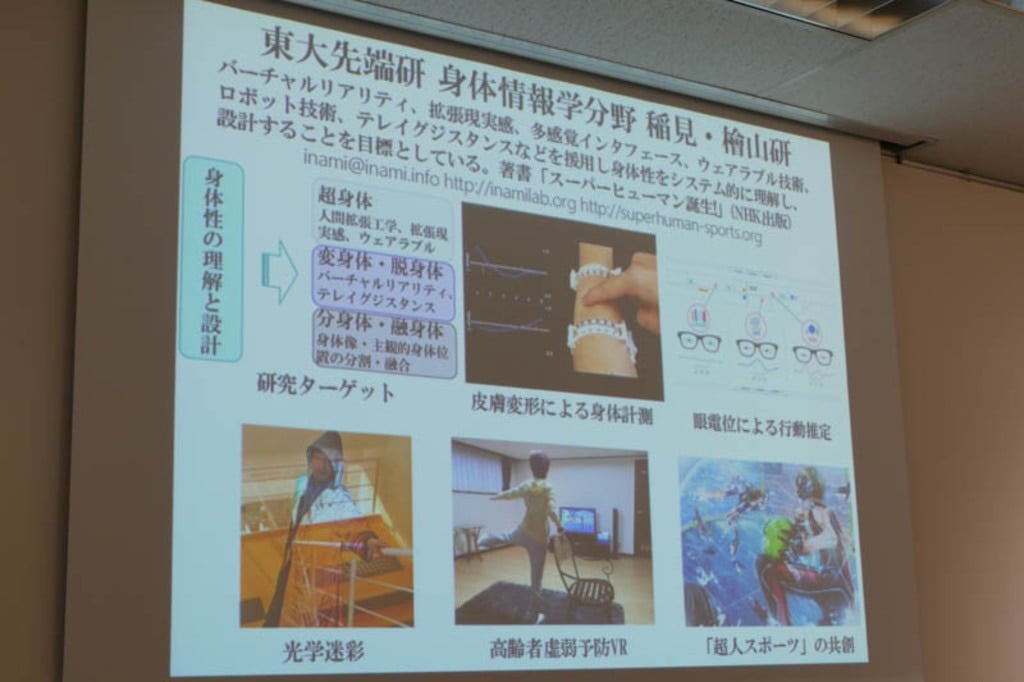

東京大学先端研 身体情報学分野 稲見・檜山研究室は、バーチャルリアリティ(VR)、拡張現実感(AR)、五感を使った多感覚インターフェイス、ウェアラブル技術、ロボット技術、テレイグジスタンスなどを使って、人間の身体というものをシステム的に理解し設計することを目標とした研究室だ。

東京大学先端研 身体情報学分野 稲見・檜山研究室

身体性を理解して再設計することで、ウェアラブルなどを使った「超身体」、VRやテレイグジスタンスによる「変身体・脱身体」、あるいは「分身体・融身体」することを目指している。アプリケーションとしては高齢者向けVRや、誰もが楽しめる「超人スポーツ」などを開発している。

研究の一例として稲見氏が最初に示したのは「JINS MEME」。メガネ型ウェアラブルデバイスで、鼻についた電極で目の動きを計測する。まばたきや眼球運動、頭の動きを記録することができる。生活空間のなかでの行動を分析するためのツールだ。

また「SenSkin」は自分の腕をタッチパネルとして使える技術だ。押したり引っ張ったりした動きを計測することでインターフェイスとして自分の腕の皮膚を使うことができる。スマートフォンなどの操作と違って、見なくてもどう触ったか、どこを触ったかがわかる。それらについては稲見氏の著書にもまとめられている。

■アニメ「サザエさん」にもVR

昨年は各社がバーチャルリアリティのゴーグルを販売し、また、「ポケモンGO」のヒットなどもあってVR元年と言われ、多くの技術者がVRコンテンツ制作に携わり始めている。アニメ「サザエさん」のオープニングにも、サザエさんが旅先で過去の風景をVRで見るといった光景が使われるくらいだ。

昨年はVR元年と呼ばれた

これまでのVRデバイスはPCと有線で接続したり、スマホを内蔵したりするものが多かったが、マイクロソフトのHoloLensは一台で完結している。空間を3次元でリアルタイム認識できる点も特徴である。稲見氏は「技術としても大変優れている」と高く評価した。

マイクロソフトのHoloLensをつける稲見教授

■バーチャルリアリティの歴史

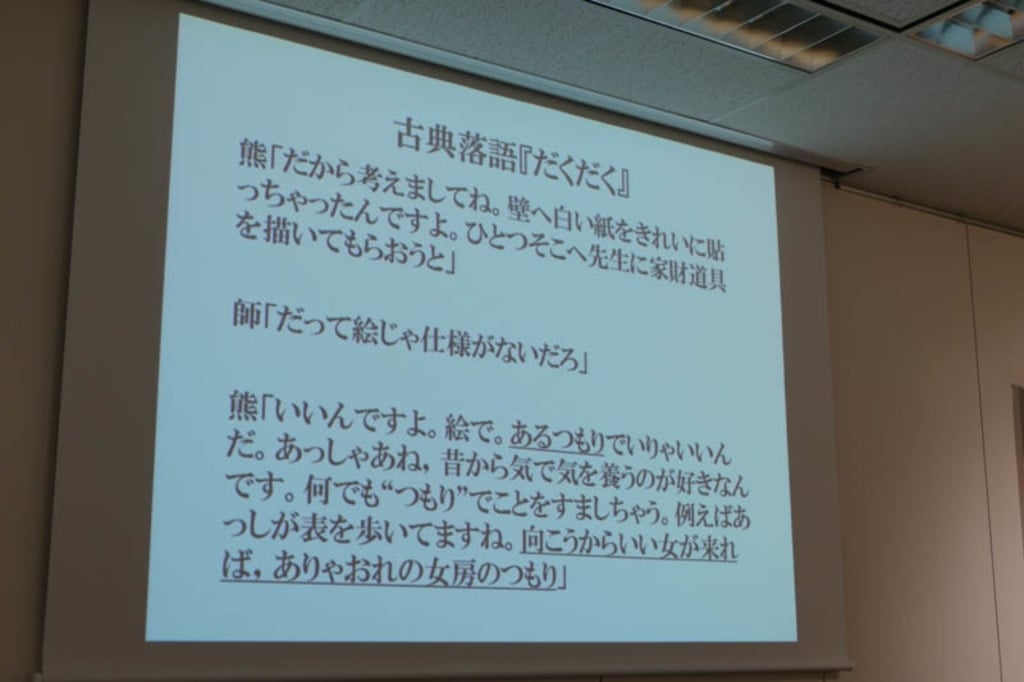

続けて稲見氏は、古典落語「だくだく」を紹介。「つもり」をうまく作ることが描かれており、そこに何かがあるようにものを示すのがVRの目指すところだという。

古典落語「だくだく」

バーチャルリアリティは仮想現実と訳されることが多いが、「virtual」とはもともとは「物理的には同一ではなくても、本質的には同じ、そこに存在するかのようなもの」という意味で、「仮想」というのはもともとは誤訳である。しかしながら他に適切な用語がなく、今も使われている。

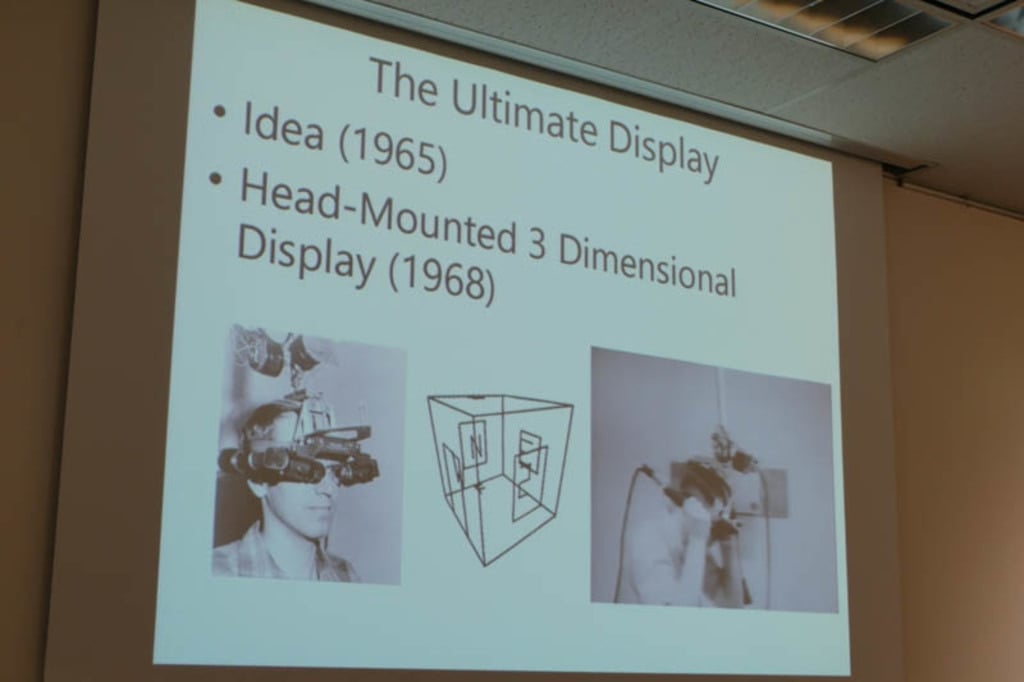

技術としての元祖はアイバン・サザーランド(Ivan Edward Sutherland)による「Ultimate Display」が嚆矢とされている。エッセイによるアイデア発表は1965年、実装され論文化されたのは1968年だ。

サザーランドのUltimate Display

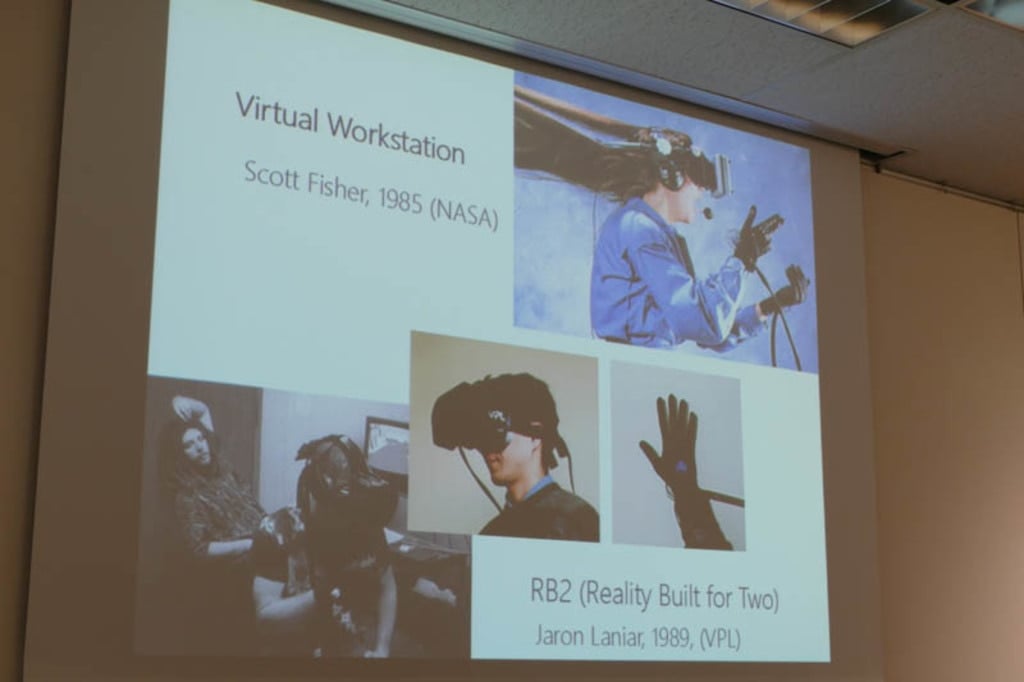

その後、NASAのスコット・フィッシャーによる「Virtual Workstation」、世界初の商用VRと言われるVPLのジャロン・ラニアーによる「RB2(Reality Built for Two)」(1989)へと展開された。1989年がもともとのVR元年と言われているのはこれが理由である。「米ソが宇宙開発を競い合っていた時期に、新たなフロンティアとしてサイバー空間の探検が行われていたことになる」と稲見氏は述べた。

Virtual WorkstationとRB2

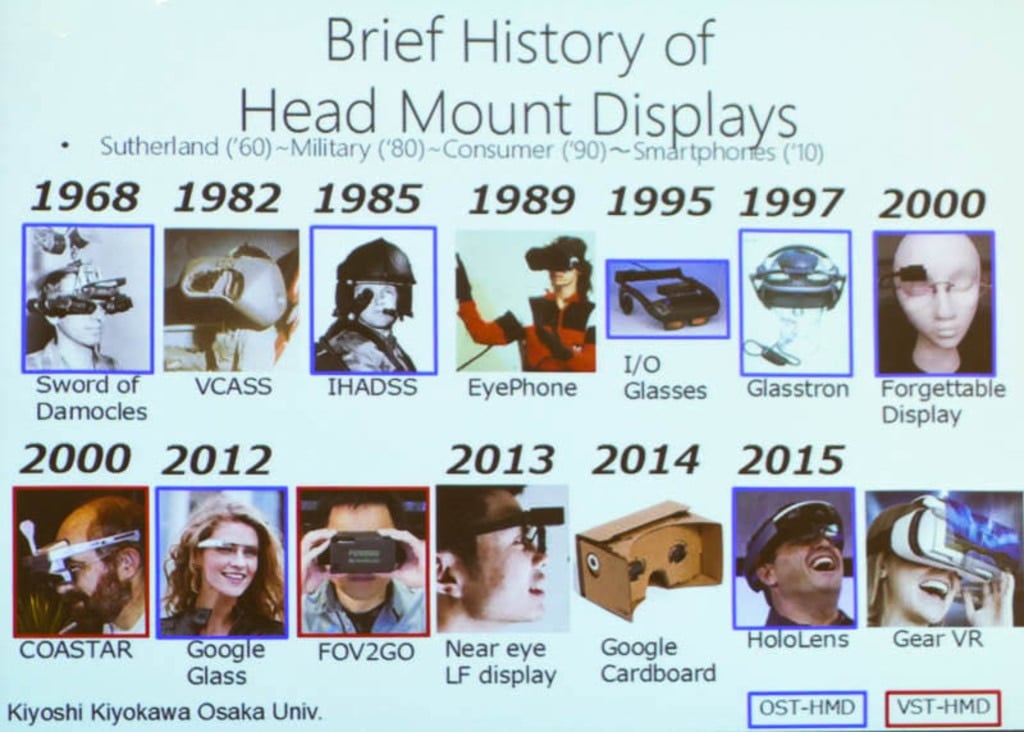

ハードウェアから見るとヘッドマウントディスプレイ(HMD)は1968年くらいから始まり、各地で研究が続き、国内でもソニーやキヤノンが研究を続けていたという。近年のGoogle GlassやHoloLensはこの系列に連なる。

HMDの歴史

「いまなぜVRか」という点を考える上で、二つの「アイフォン」が重要だという。1989年のEyePhoneと2007年のiPhoneである。1989年当時は非常に高価で、真面目な使い方しかできなかった。ただし研究者コミュニティは生まれた。iPhoneは言うまでもなく世界を変えた。今は「スマートフォンをバラすとIoTであり、レンズをつければVRになるとも言われている」そうだ。

二つの「アイフォン」

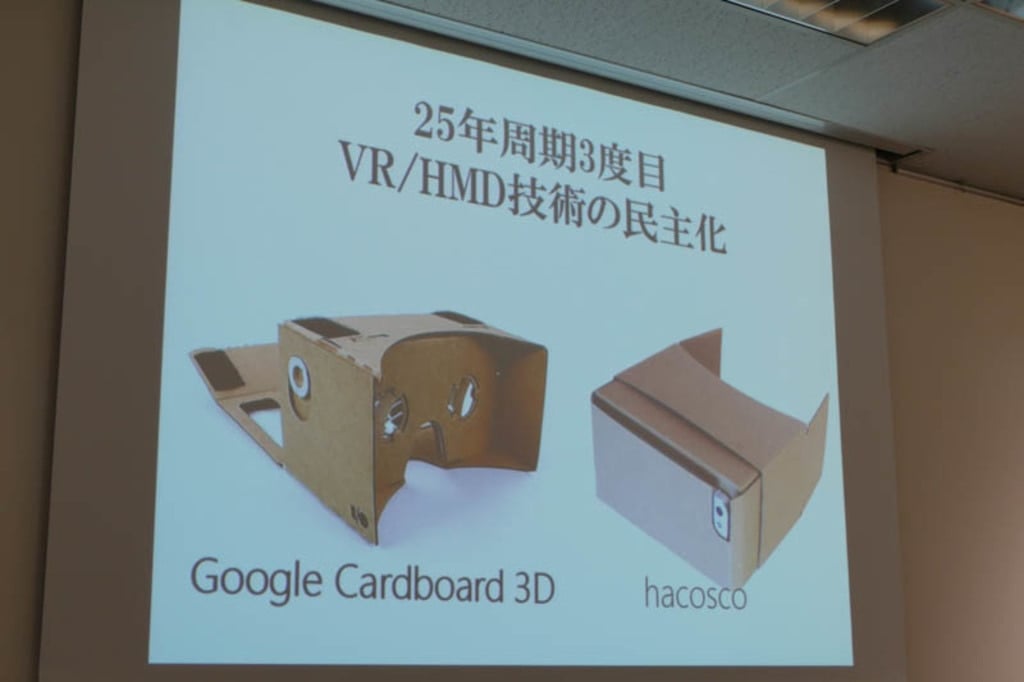

いまのVRブームはVRやHMDの技術が安価になり民主化されたことによるが、今回が3度目であり、25周年周期でやってきているという。

中国ではいまVR関連のヘッドギアが多数並んでいるとのことだ。カジュアルにVRが体験できるようになっている。

かつてメインフレームが当たり前だったコンピュータがデスクトップ、ラップトップを経てノートPCになったようなものだ。

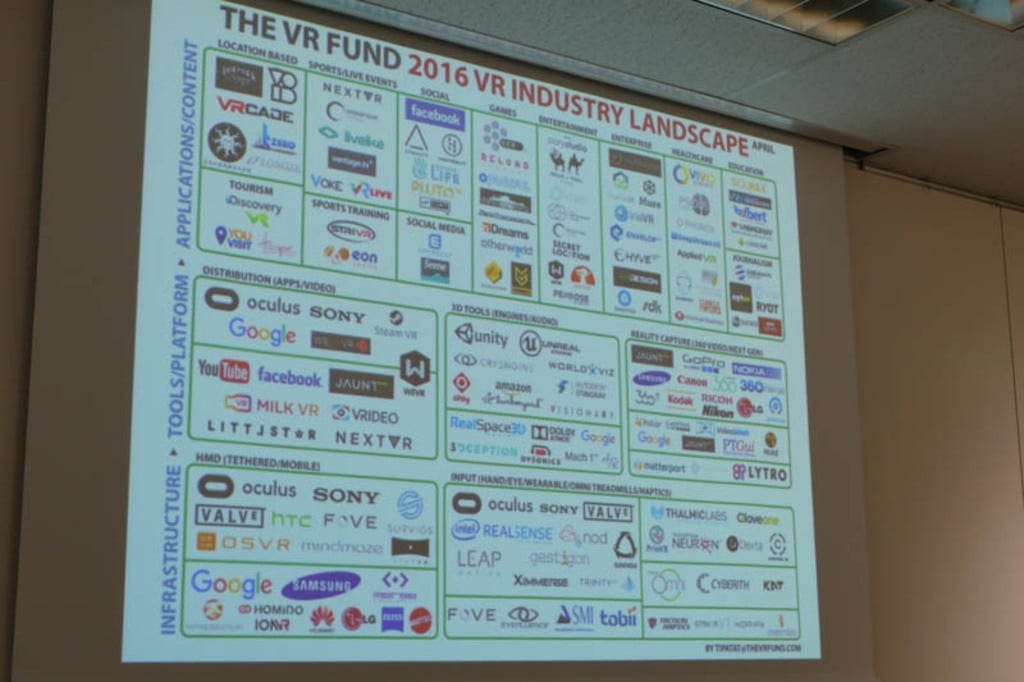

インターネットが商用化されていったように、限られた研究者が使うだけではなく、アイデアを簡単に実装し、趣味にも使えるようになっている。いまや多くの企業が産業応用を検討している。

安価になったHMD

「特に、unityのようなインタラクティブな3DCGを簡単に作れる3Dツールキットの貢献は大きい」と稲見氏は指摘した。これまでゲームエンジンとして使われていたものが、VRに使われるようになっており、そこを中心に各プレイヤーがつながっている。

3Dツールキットが重要だという

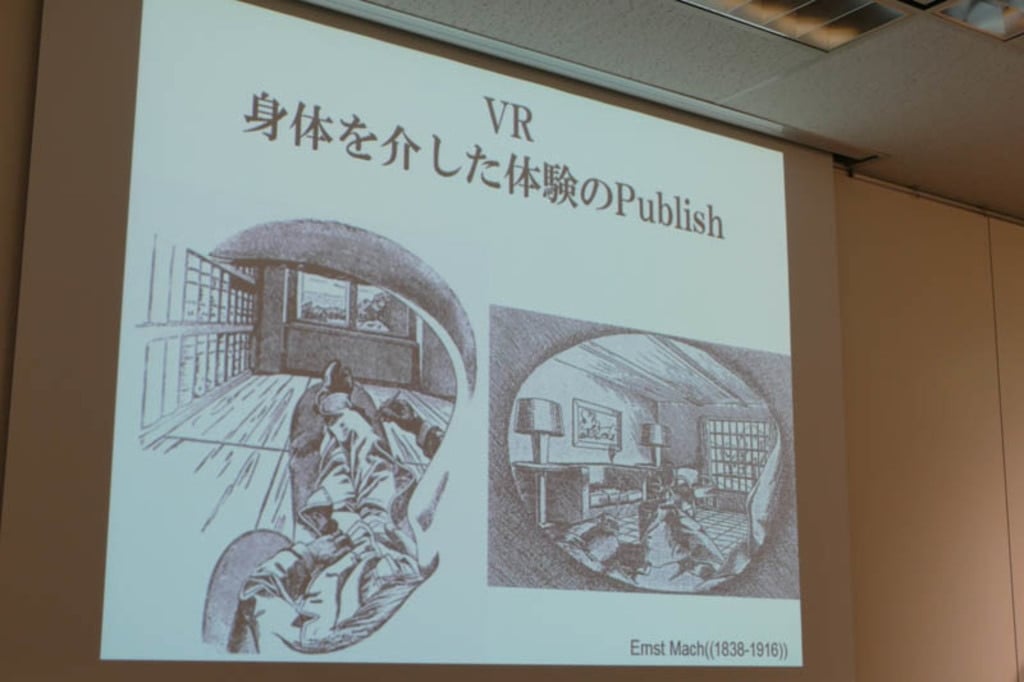

■VRは一人称体験を他者と共有する技術

身体を使った体験を他者と共有できるツールがVR

では、VRをどのように位置付ければいいのか。稲見教授は、「VRは我々の身体を介した体験をPublishできる初めての技術ではないか」と述べた。これまでは何かを共有するときには、客観的なものをパブリッシュするのが限界だった。身体の動きを通した体験、一人称体験を、一人称のまま他者と共有できるようにするのがVRだというわけだ。

稲見教授は愛知工科大学工学部 板宮研究室の「Virtual flood」というデモを紹介した。津波シミュレーターである。

愛知工科大学工学部 板宮研究室「Virtual flood」

世代を超えて起こるような低頻度巨大災害もVRを使えば継承することができる。他人事ではなく、自分ごと、一人称として体験可能にできるVRならではである。

■VRは人の欲求を満たす

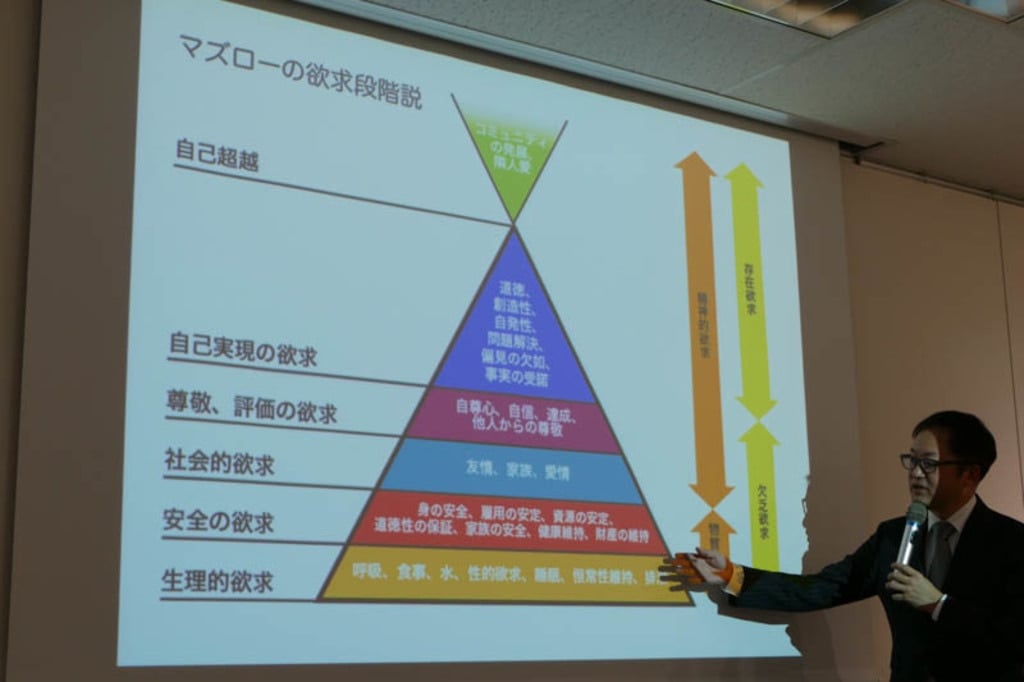

VRで可能になることとして、稲見氏は「マズローの欲求段階説」の図を示した。VRは、実世界では無理だった多くの欲求段階を満たしてしまえる可能性がある。

現実世界では無理だった社会的欲求や自己実現の欲求の実現がオンラインゲームでも代替できるというのは、体験したことがある人ならばわかりやすいのではないだろうか。問題は図の下のほう、安全、生理的欲求をどう満たすかであるという。

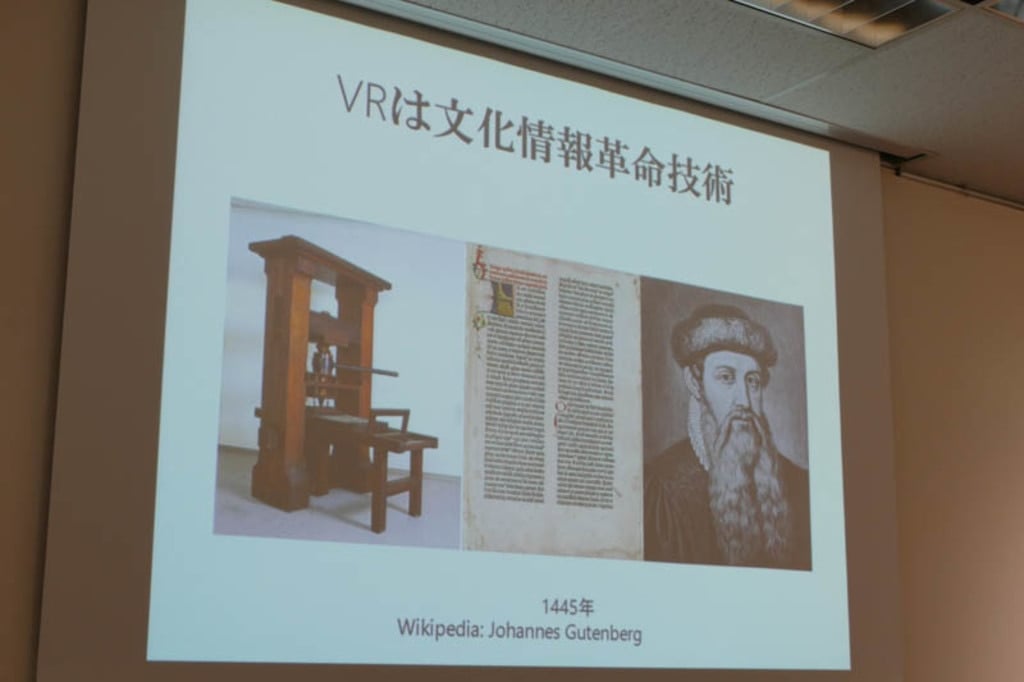

これらを踏まえて、稲見氏はVRは産業面の革命というより、IT革命の延長にある文化情報革命技術だと位置付けた。

マズローの欲求段階説

VRは文化情報革命技術

■HMDの高度化

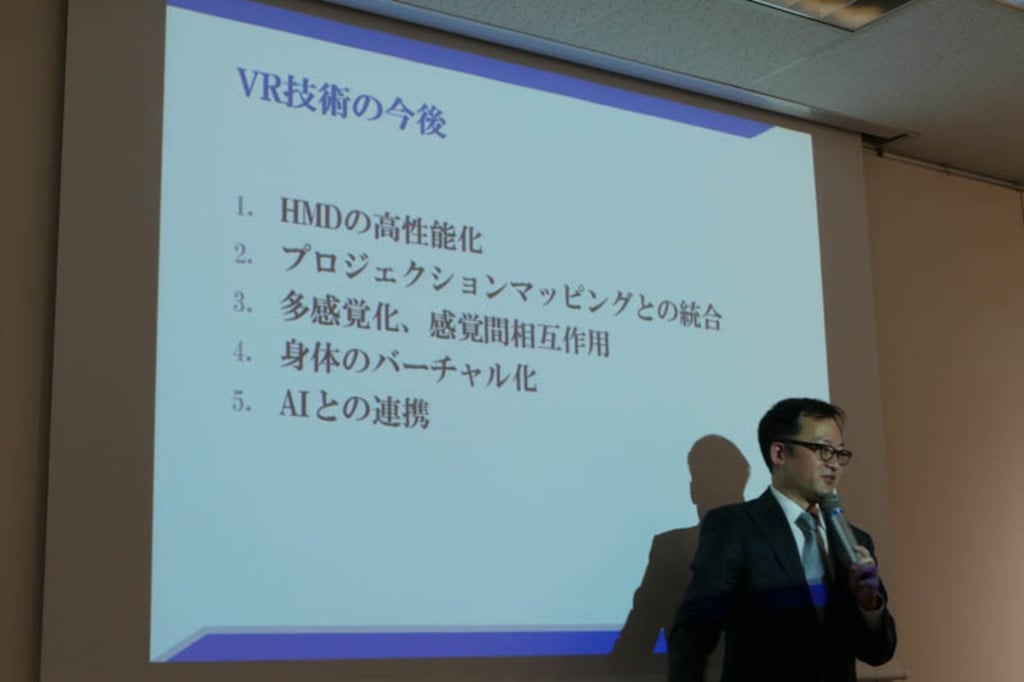

VR技術の今後としては、

1)HMDの高性能化 2)プロジェクションマッピングとの統合 3)多感覚化、感覚間相互作用 4)身体のバーチャル化 5)AIとの連携

の5つを挙げた。

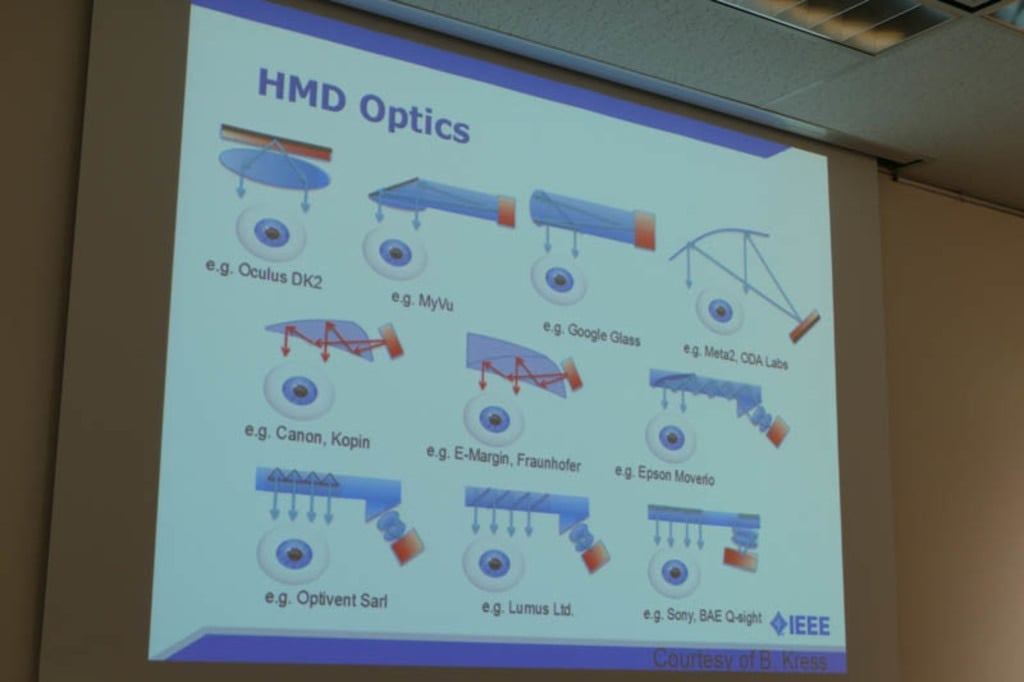

まず、HMDの高度化については、現在、様々な光学系が検討されているが、ポイントはシンプルであり、近くのものを見るために必要な老眼鏡と同じだ。度の強い老眼鏡をかけると、ごく近くのものも見える。要するに、ディスプレイを目に近づければVRになるが、ピントが合わないのでレンズを使ってピントをどう合わせるかという問題なのである。

VR技術の今後

HMDの光学系の研究

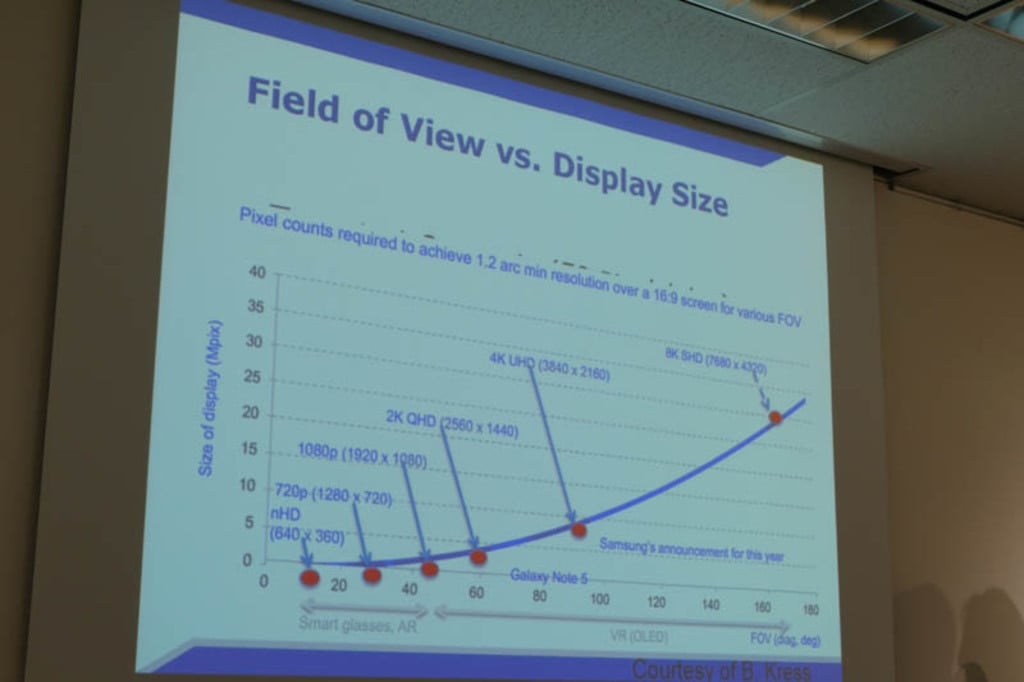

ディスプレイの視野角とサイズをどうするかが課題だが、どんどん大きくなっており、やがては8Kに達すると考えられている。90年代VRのときには「体験としては面白いが解像度が低い」という指摘があった。

だが解像度を上げると処理が重たくなって追随性が悪くなり、その結果、VR酔いが生じてしまい、価格も高くなってしまう。それと同じ問題は今もある点には注意が必要だ。ただし、いまはソフトウェア処理も早くなっている。

ディスプレイの視野角とサイズ

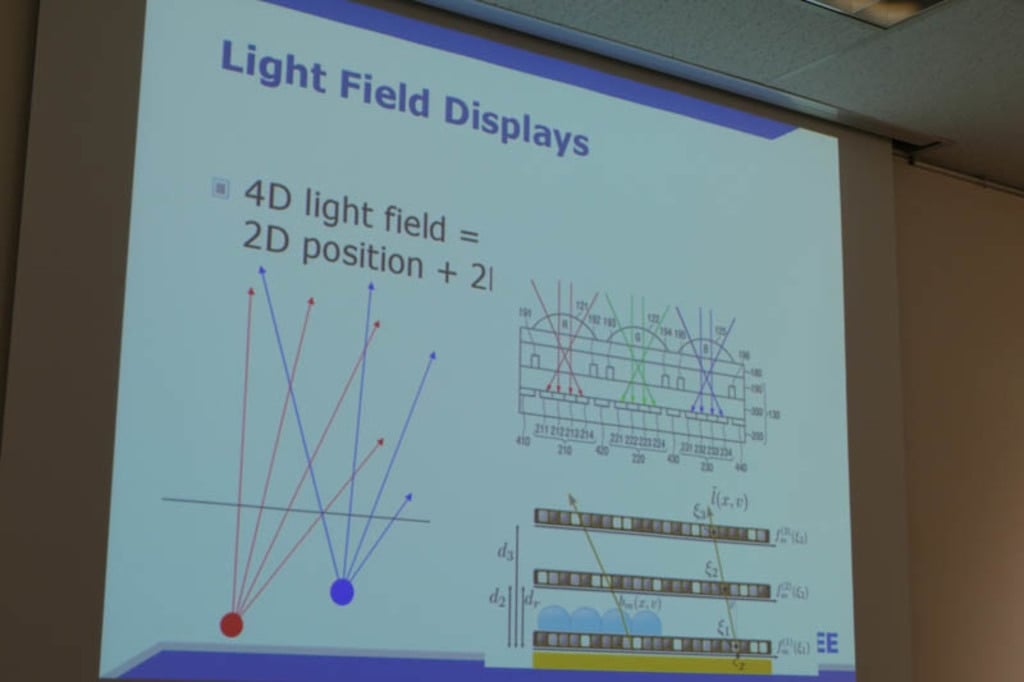

より計算機の速度が速くなった状況で期待されているのは「ライトフィールドディスプレイ」である。いったん撮影したあとでピントを変えられる「ライトフィールドカメラ」で実装されている技術と基本的には似たものだ。

今までは撮像素子に入った光を点でしか記録できなかったが、ライトフィールド技術は光の方向まで記録する。つまり、光線を光線として記録できる。それによって、ピントを後から任意のところに合わせることができるのがライトフィールドカメラである。

いっぽう、「ライトフィールドディスプレイ」は計算技術を使って光線をきちんと再生できるディスプレイだ。ピントの位置を自在に設定できる技術だ。

ライトフィールドディスプレイの原理

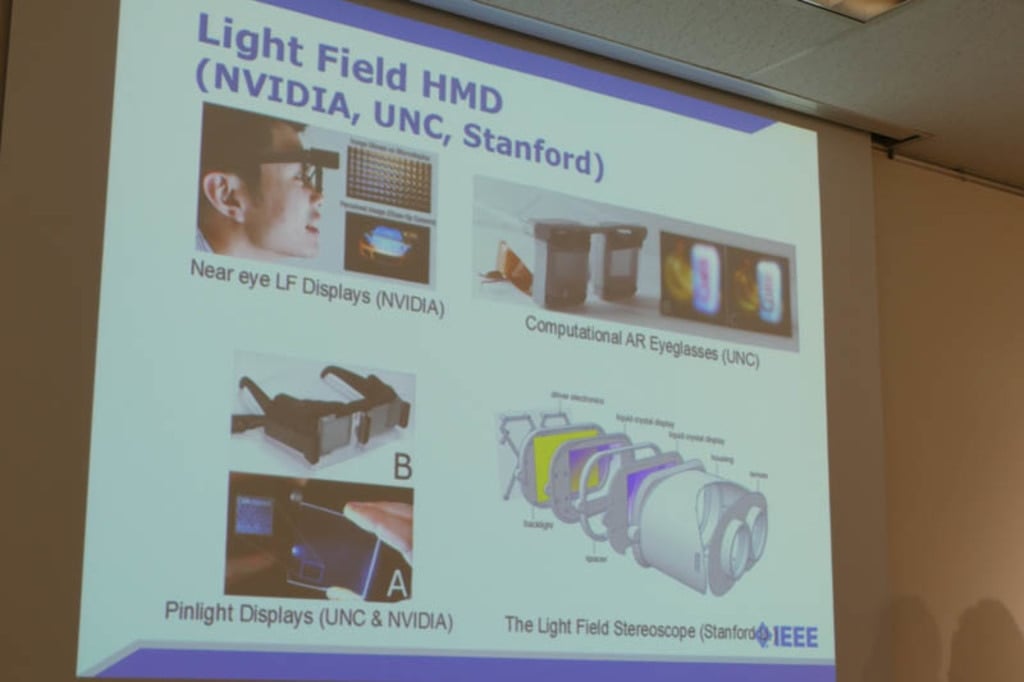

ライトフィールドHMDの開発がいま、NVIDIAやUNC、スタンフォードなどで始まっている。

多くのVRデバイスは目のピントが合う位置が1m程度に固定されている。輻輳調節のズレが眼精疲労の原因だと言われているが、任意の位置にピントを合わせた像を出力できるライトフィールドディスプレイを使えば、それが解決できる。ホログラムを実現できるようなものだ。

NVIDIAやUNC、スタンフォードがライトフィールドHMDを開発中

現時点のライトフィールドディスプレイは複数のピクセルをまとめて一つのピクセルとしているため解像度が低い。その計算量の問題もあって、「現時点でこれがパッと広まることはないが、これが出てきたとき、ディスプレイ技術が根本から変わる」と稲見氏は述べた。

スタンフォードによるライトフィールドディスプレイ技術の紹介ビデオ

たとえばメガネをかけている人は、メガネを外すとピントがボケてしまって何も見えない。だがライトフィールドディスプレイを使えば、任意のピント画像を出力できるので、メガネをつけない状態でもディスプレイがはっきり見えるようになる。

スマホであっても、普通に使っているときはスマホだが、目にそのまま近づければレンズがなくてもVRゴーグルということが可能になる。ディスプレイの位置自体をバーチャル化することがコンピュテーションによって実現できる可能性がある。

なお、Magic Leap社はライトフィールドを作っていると主張しているが、詳細は不明だ。

Magic Leapのデモ動画

■空間型VR/AR プロジェクションマッピングとの統合

プロジェクションマッピングとの統合は専門的には空間型VR/ARと言われる技術だ。イリノイ大学による「CAVE」(1992)のような、人のまわりを丸ごとスクリーンで覆う、イマーシブ(没入型)多面プロジェクション技術の延長上にある。日本でも90年代に研究された。

マイクロソフトリサーチは現在プロジェクターとディスプレイを組み合わせた「IllumiRoom」という技術を開発中だ。エフェクトとして周囲の家具なども動かすようなことができる。

空間型VR/AR

マイクロソフトリサーチ「IllumiRoom」

当時はきちんとしたスクリーンがないと映像を提示できなかったが、凹凸があるところでもリアルタイムに計測して補償した投影ができるようになっている。エンターテイメントにも使われており、いまでは演劇などにも使われている。

「ヒックとドラゴン」の演劇で使われている例

2016年末のNHK「紅白歌合戦」ではライゾマティックスが「Dynamic VR」という技術を披露した。平面にもかかわらず、3D空間のように見えるように投影ができるという技術だ。

ライゾマティックス「Dynamic VR」

空間型のVRは、どういうことが起きているかは近くにいる人もわかる。観客を引き込むような効果が期待できる点がゴーグルとは違うところだ。

また、頭部の位置に合わせて映像を動かすことで立体に見せることができる技術も今では簡単に実現できるようになった。関連として稲見氏は、自身の研究である再帰性反射材を使った「光学迷彩」や、それを応用した「透明プリウス」の研究を紹介した。

光学迷彩。後ろのポスターが透けているように見える

■五感を使う多感覚化

多感覚化とは、視覚や聴覚だけではなく、触覚そのほか五感をもっと活用したVRである。リアルかどうかは触覚から得ている部分も多いからだ。まずは「共感覚スーツ」を紹介した。また「Nintendo Switch」は、触覚をVRにしたデバイスとしても見ることができ、実装している「HD振動」がそれだと述べ、触覚を振動として記録・再生できる慶應義塾大学の南澤氏らによる「TECHTILE toolkit」を紹介した。

TECHTILE toolkit

また心臓の鼓動を離れている人のところに伝えるデバイス「SMASH」は、単純だがコミュニケーションにおいては効果的なデバイスだと紹介した。

心臓の拍動を伝える「SMASH」

空間型の触覚デバイスも研究されている。稲見氏は、映像が指にあたったときに超音波で触覚を引き起こす「Tochable Holography」や、空中にものを浮かす「Pixie Dust」、香りを再生し感覚間相互作用を利用した「メタクッキー」、失禁体験装置「ユリアラビリンス」など各種研究を紹介した。

Pixie Dust

■VRで自分の身体も変えられる

世界をどう作るかという話になりがちなVRだが、技術を使えば自分の身体も変えられるという。それが「身体のバーチャル化」だ。

映画「君の名は。」は男女が入れ替わる映画だったが、稲見教授からすれば、相手に変身することで、相手の社会的役割などを理解できる新しいコミュニケーション手段としても見ることができたという。

この手の入れ替わりはメディアアートとしても作られている。

またスポーツ選手の体験を記録し、VR装置で再生することで追体験することもできるようになっている。まさに自分が他人の体に乗り込んだような感覚が実現できるようになっているという。

VRスポーツ体験ができるJackin Head

これらはエンターテイメントだけではなく、様々な人たちを観察するのではなく、実際に対象に変身することで商品開発に参加するための創造的ツールとしての可能性を示しているという。また他者を理解する新たな手段として、人種差別などを克服する手段にもなり得るのではないかと研究を紹介した。

人種差別をVRで減少させることも可能かもしれないことを示唆する実験

身体のシェアードエコノミーの可能性もある。VRを使えば、自分の身体をクラウドソーシングを通して他者に貸すことができるようになる。これはテレプレゼンスの話に繋がる。

リアルな人間のアバターを使ったテレプレゼンス「Omnipresenz」

■人の移動速度を光速に変えるテレプレゼンス技術

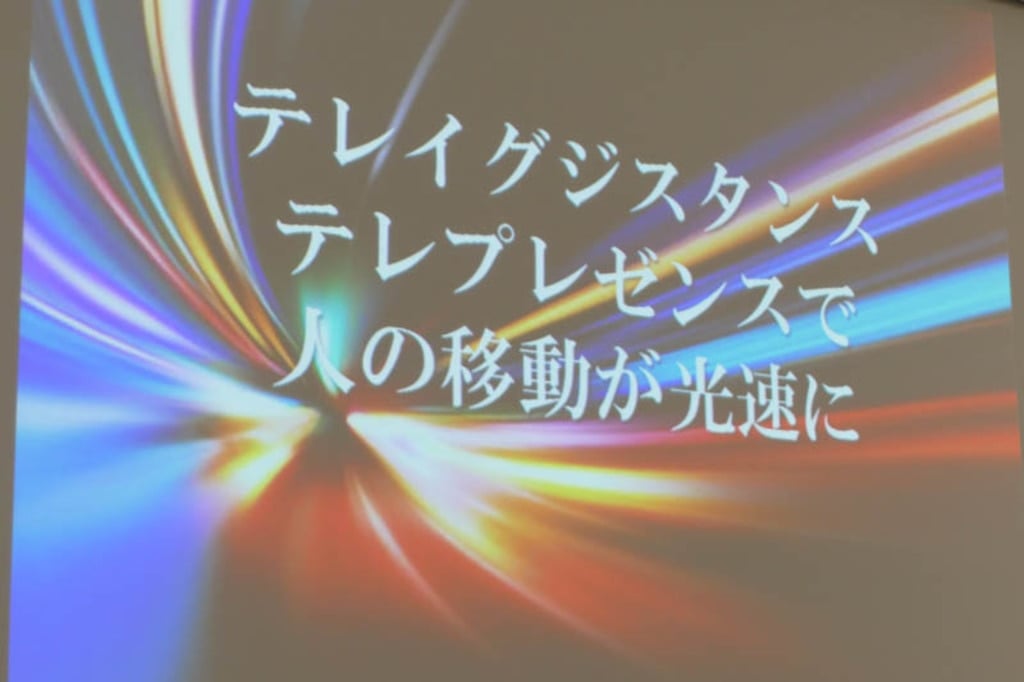

テレイグジスタンスやテレプレゼンスは、人の移動を光速に変える技術として解釈することもできるという。VR技術を使って自分の動きが乗り移ったかのように直感的にロボットを操作する技術は、遠隔重機操作にも使われている。

Clusterはバーチャルカンファレンスを行うためのツールだ。miklusもある。ANAはAVATAR Xprizeをサポートしている。ANAは人を運ぶのがビジネスだが、テレイグジスタンスは対極的な技術であり、そこに今から参入することで新たな可能性が拓けるかもしれないと考えているのだという。

人の移動を光速に変える

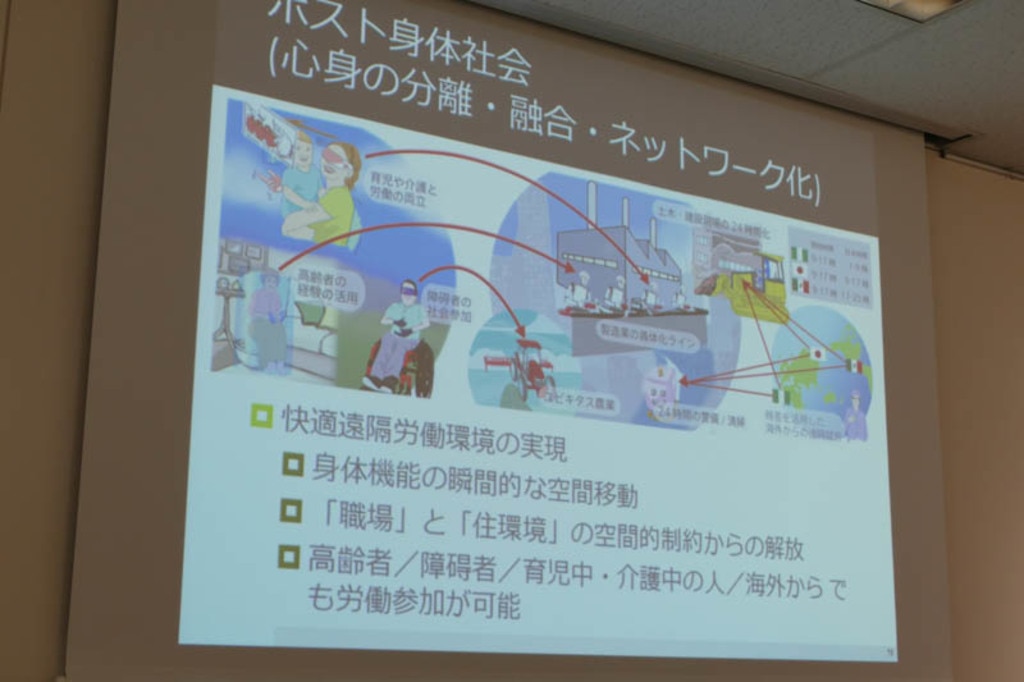

身体を使うような作業も全部オンライン上でできるようになるかもしれない。身体の移動コストがゼロに近づいてきたとき、働き方がどう変わるのか。工場なども外部からアクセスすることで違う働き方がありえる。海外の人が工場の何かにログインして操作すればいいのだ。

ポスト身体社会が来る

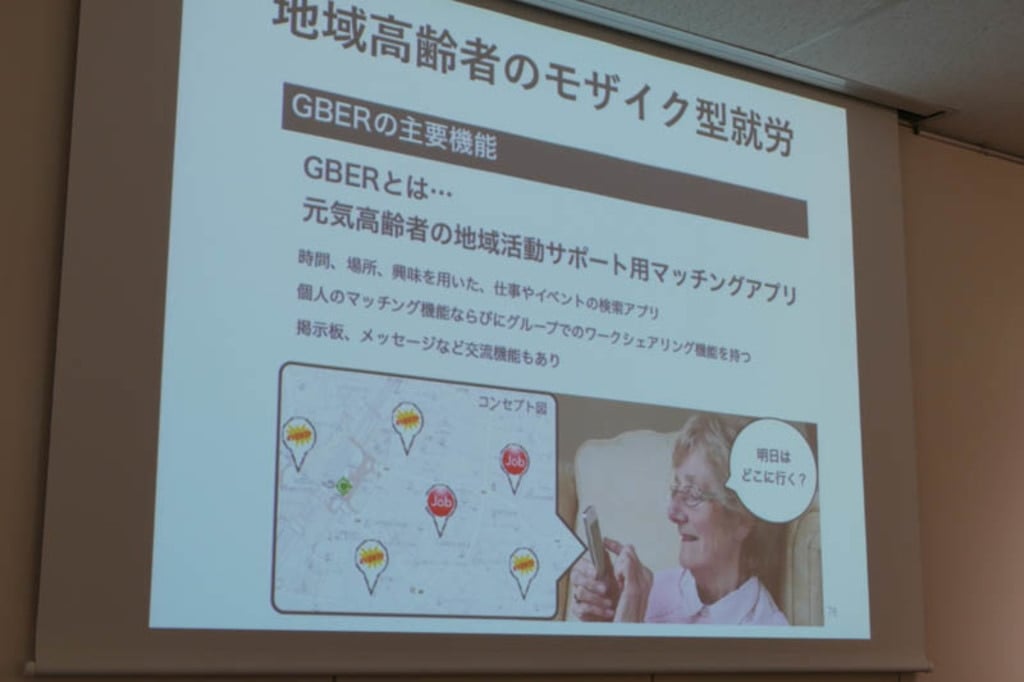

「GBER」は稲見・檜山研究室で檜山氏らが進めている高齢者支援のシステムで、柏市で実証実験を行っていると簡単に紹介した。

GBER。名前はUBERのもじり

■VRとAI AIがVR空間を生成する時代

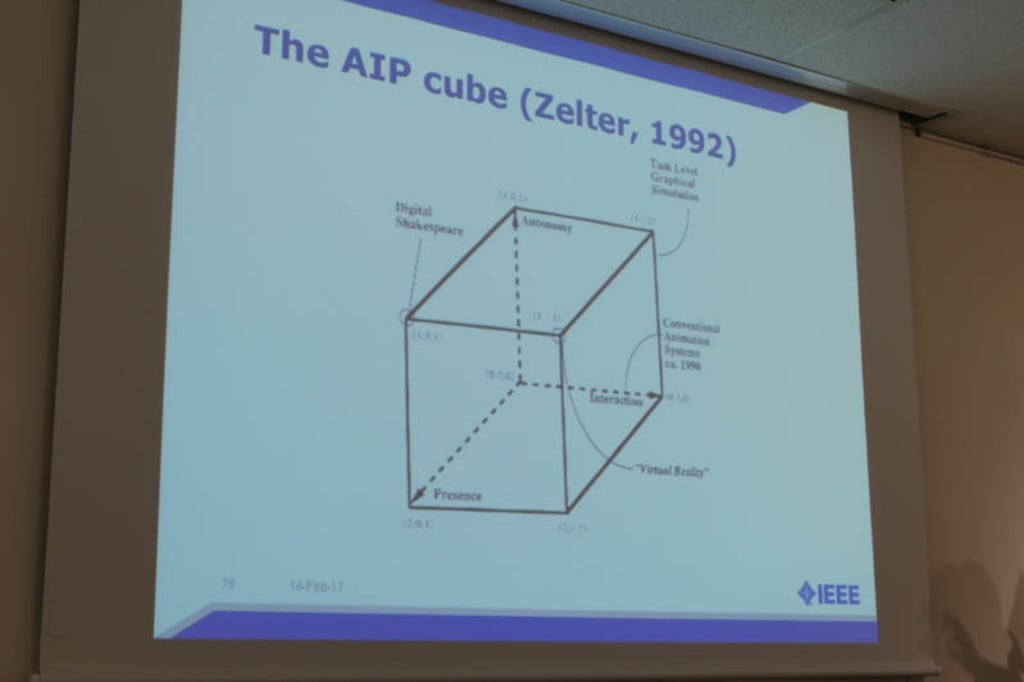

稲見氏は、「AI」はおそらく、ITやコンピューターという言葉と同じような意味で使われるようになるだろうと考えているという。ではAIとVRはどう関係するのか。稲見氏は「AIP cube」という考え方を紹介した。

AIP cube

自律性、インタラクション、プレゼンスの3軸のうち、自律性をリッチにするにはAIが必要となる。

景色や空間を自動生成するような技術が今後、VRのなかで多く使われるようになる。VR空間をAIが無限に作る時代がやってくる。今後のメタバース(インターネット上に存在する仮想空間)は一人が数十持つ時代がやってくるという。

一人の人が様々な自律的に生成されたバーチャル世界を持っていて、そのなかで仕事をしたり楽しんだりするのが今後のVRとAIの世界だと考えているという。

自動生成された風景

■誰もが能力を発揮する世界へ

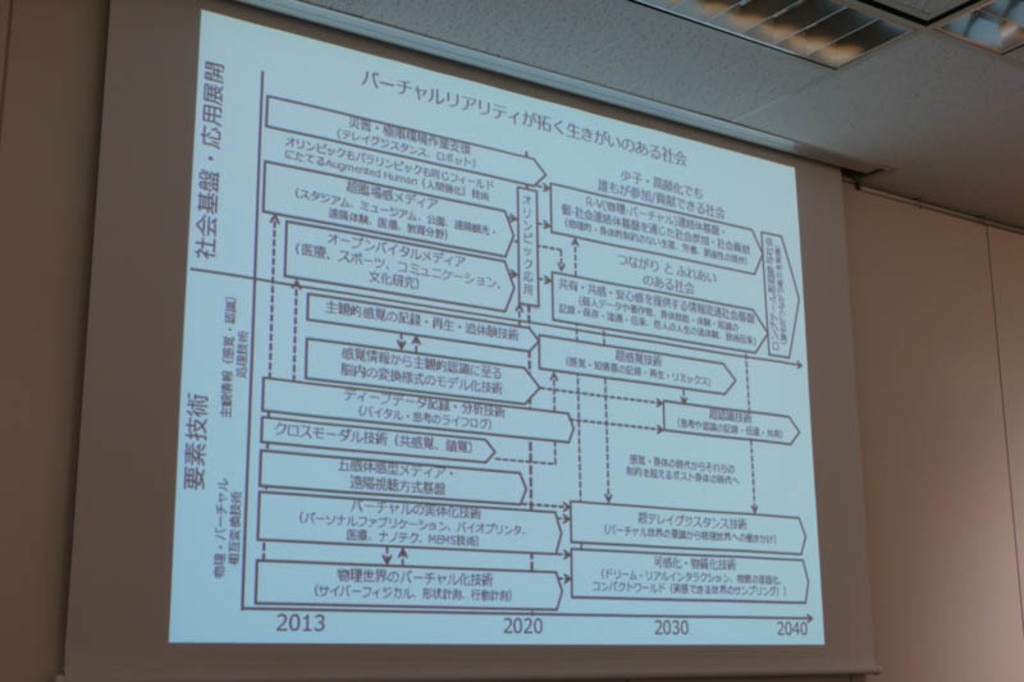

最終的にVRが作る世界はどんなものになるのだろうか。稲見教授は、誰もが好きな時にどこにいても、能力が発揮できるような世界であると述べた。

エンターテイメントと労働の違いは、誰かからやらされているのか、それとも自発的にやっているのかという点にある。VRやARの技術が実際に使われるときは、「やりたいこと」を支援するということが重要なことだと述べて講演を締めくくった。

質疑応答では、ロボット技術との関連や、今後の応用に関連した質問が出た。一番の肝は、VRとリアルをどう繋げるかにあるという。VR空間で何かを買ったりしたとして、それをどうリアルに持ってくるのか。あるいはリアルにあるものをどうVR空間に持っていくのかという問題だ。

VRが拓く世界

TECHTILE toolkitを手に解説する稲見教授